AI og dens problemer forklaret på 5 minutter

En af de hotte debatter for tiden er AI, og en lang række forskere har netop været ude og advare imod farerne ved AI. Jeg vil anse mig selv som yderst erfaren i computere, men upåagtet har jeg stadigt svært ved, at begribe præcis hvordan f.eks. ChatGPT er kommet dertil, hvor den er - også selv om jeg (tror) jeg forstår de bagvedliggende principper.

Jeg vil her forsøge at forklare det ved at forsimple det groft, og efterfølgende forklare hvorfor jeg også synes det kan være problematisk.

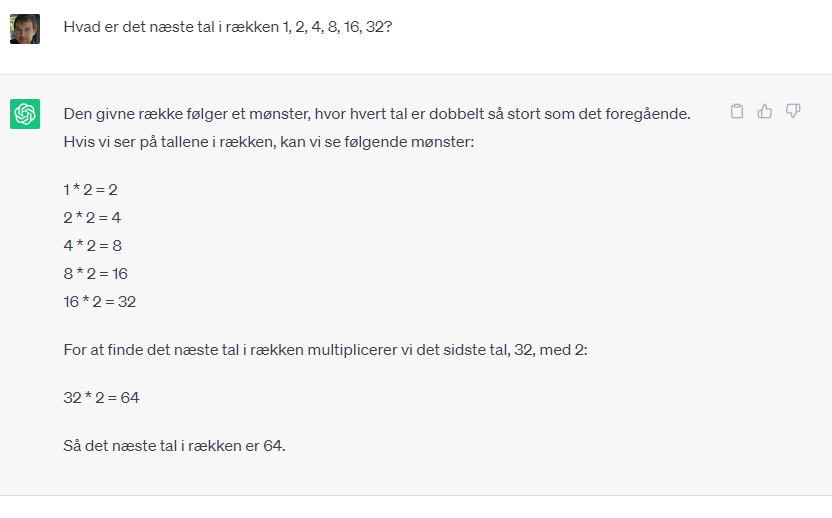

Lad os tage et simpelt problem, f.eks. en tal-række som er en fordobling af det foregående tal: 2, 4, 8, 16, 32 osv. Det ville være meget let at programmere et program, der kunne vise denne talrække og lige så let, at programmere et program, der givet et tal i denne række, kunne vise det næste tal.

Men man kunne også træne en AI på dette problem. En AI er grundlæggende en algoritme, der tager noget inddata og ud fra dette, giver noget uddata. Så i dette tilfælde, ville jeg forvente, at når jeg gav den inddata = 2, så ville jeg få uddata = 4 eller hvis jeg gav den inddata = 16, så ville jeg få uddata = 32.

Når man starter med en AI-algoritme, så ved den absolut ingenting. Det er blot en forbindelse af tal, vægte og forbindelser, der vil agere helt tilfældigt. Men det interessante er, at algoritmen kan modificere sig selv, baseret på om den gør det godt eller skidt.

F.eks. kunne udgangsalgoritmen være så simpel, at den blot returnerede det samme, som vi giver den som inddata. Dvs. hvis jeg gav inddata = 2, så ville jeg få uddata = 2. I dette tilfælde ville det forventede svar være 4, så derfor ville jeg markere, at algoritmen havde gjort det dårligt. Baseret på dette vil algoritmen modificere sig selv, for at forsøge at komme med et bedre svar næste gang. Vi kunne forestille os, at den f.eks. modificerede sig til at lægge 10 til inddata, dvs. at når jeg giver inddata = 2, så får jeg uddata = 12, hvilket er lige så forkert og så ville jeg markere "dårligt" igen. Dette kan blive ved i en rum tid, men på et tidspunkt vil den ramme noget der kunne være rigtigt. Vi kunne f.eks. forestille os, at den ramte + 2 dvs. at lægge to til tallet. Så når jeg gav den mit inddata = 2, så ville jeg få uddata = 4, hvilket er et godt svar. Jeg ville markere for "godt". Glæden ville dog være kortvarig, for når jeg så sagde inddata = 4, så ville jeg få uddata = 6 og ikke 8 som jeg havde håbet. Så her ville det være dårligt igen. Men algoritmen ville vide den havde haft fat i noget, og før eller siden, ville logikken for + 2 blive til x 2, og så ville jeg pludseligt have en tilfredsstillende algoritme.

Dette er grundlæggende AI-træning og det kan automatiseres, for i stedet for, at jeg som menneske skal sidde og evaluere resultater i en uendelighed, kan jeg i stedet lave et lille program, som jeg fodrer med første del af talrækken dvs. 2, 4, 8, 16 og 32, og så kan mit program blive ved med at give disse tal som inddata, og vurdere algoritmens uddata som "godt" eller "dårligt", indtil den kun returnerer "godt". Og så ville jeg nærmest automatisk have trænet en fordoblings-AI.

Hvis vi ganger denne kompleksitet med mange milliarder, så er det faktisk på præcis samme måde ChatGPT fungerer. Her har vi bygget en tilsvarende algoritme, men i stedet for at forudsige næste tal i en talrække, så har vi trænet den til at forudsige næste ord i en samtale. Og i stedet for at have trænet den på en talserie af 5 tal, så har vi trænet den på alle de tekster, vi på nogen måde har kunnet komme i nærheden af. Den har uden tvivl gennemtrawlet hele Wikipedia, hele Reddit og alle artikler som Google nogensinde har indekseret, blot for at sætte en begyndelse. Herefter er den også blevet trænet utallige timer af mennesker, for at sikre, at dens output er i form af en samtale, og for at sikre at de svar den kommer med, ligger indenfor nogle etiske rammer. Og vupti, så har vi en teknologisk samtalepartner, som verden aldrig har set mage før.

Men det store problem er, at den algoritme som computeren har designet, for at kunne dette, har sådan en stor kompleksitet, at intet menneske er i stand til at gennemskue hvad den gør og hvordan dens logik er konstrueret. Det er milliarder af tal, vægte og forbindelser som computeren har konstrueret, for at give tilfredsstillende uddata på det inddata vi fodrer den. Vi kan på ingen måde redegøre for, hvordan den kommer til sit uddata, men vi kan blot konstatere, at det uddata vi får, tilsyneladende er i overensstemmelse med det inddata vi giver. Indtil det ikke er det.

Hvis vi går tilbage til vores simple algoritme, så kan det godt være, at vi tror computeren har designet en algoritme som ganger med to, men i virkeligheden har den konstrueret en helt anden logik, der tilfældigvis giver de samme resultater... indtil den ikke gør. Det kunne være, at når vi nåede til 1048576, så var næste tal 25, uden at vi kunne sige hvorfor.

På samme måde ser vi, at ChatGPT er designet til ikke at komme med racistisk output... Indtil den gør det alligevel.

Vi har ligeledes set, at Snapchat har designet en AI-kammerat, der er designet til børn... Indtil den vejleder i selvskade.

Og vi har set Teslas selvkørende bil, der sikkert kan køre sig selv... Indtil den kører frontalt ind i en lastbil.

Og det er det som er faremomentet. Vi tilslutter algoritmer, vi grundlæggende ikke kan redegøre for hvordan fungererer, til ting som potentielt kan være farlige. Eller på sigt - er designede til at være farlige, såsom våben.

Efter min mening bør vi føre en strengere lovgivning omkring vores elektroniske tjenester og internettet generelt. Det nytter ikke noget, at vores børn kan komme ind på alverdens tjenester, blot fordi de sætter kryds i "Ja, jeg er over 13 år" eller fordi de kan stave til "Pornhub", og det nytter heller ikke, at Youtube ikke er ansvarlig for f.eks. henrettelsesvideoer, fordi "det jo var en bruger af tjenesten, der lagde det op". Og på samme måde nytter det heller ikke, at vi undslår os ansvaret når AI-tjenester løber løbsk, fordi "vi jo ikke kan gennemskue algoritmen".

Hvis vi kan stille teknologien til rådighed, må vi også tage det samlede ansvar for, hvad den teknologi kan bruges til og resulterer i! Og hvis vi ikke er klar til det, ja så er vi nok ikke klar til teknologien...